"¿De qué le sirve al hombre ganar el mundo entero si arruina su vida?"

Mc. 8, 36.

"Pura es la austeridad practicada con sincera fe, sin apetencia del fruto de la acción ni esperanza de recompensa"

Bhagavad Gita.

Parece que hay quien es capaz de suicidarse por alcanzar la gloria. Que ésta sea laica o sagrada parece asunto menor ante la importancia de ser alguien relevante, famoso.

Tradicionalmente se habla de famosos como de aquellos que son reconocidos por muchos en razón de algo. Con frecuencia, ese algo se olvida y, con ello, también el alguien que lo logró. La mayoría de quienes son honrados en nombres de calles son también perfectos olvidados por quienes por ellas transitan.

La fama ya no es lo que era. Y es que, en tiempos lejanos, la fama era la gloria, aunque nadie supiera decir qué significaba eso. Sabemos que Aquiles prefirió la gloria heroica a una vida prolongada pero común, gris. Y heroicas aparecen las figuras de muchos personajes históricos.

La fama gloriosa es apoteósica, pues sólo parece posible tras la muerte del héroe. Ese término, “héroe”, ha sido tomado incluso por la Iglesia católica para honrar con la canonización a quienes, según ella, han vivido las virtudes cristianas en grado heroico, aunque no aclare qué significa eso, exceptuando el caso del martirio por confesión de la fe.

Pero hay quien disfruta (o sufre) de su fama en vida. Como reconocimiento. De hecho, son muy abundantes los artistas y cantantes famosos, en muchos de los cuales tal condición puede acabar siendo letal.

No todo el mundo puede actuar como Marlon Brando o cantar como María Callas. Es normal que esa peculiar mezcla de don y trabajo sea reconocida, aplaudida, por muchos. Es normal que se les haga famosos y que, desde la impresión de sus manos en el paseo de Hollywood hasta el registro de su opinión sobre cualquier cosa tengan mucho valor para muchos. Y es que la fama implica lo cuantitativo, la exposición de lo único a muchos, supone el espectáculo. Y nada más espectacular que el fútbol o la belleza. No es sorprendente que los mejores futbolistas se emparejen con misses y modelos (término que ya es definitorio de por sí).

No todo el mundo puede actuar como Marlon Brando o cantar como María Callas. Es normal que esa peculiar mezcla de don y trabajo sea reconocida, aplaudida, por muchos. Es normal que se les haga famosos y que, desde la impresión de sus manos en el paseo de Hollywood hasta el registro de su opinión sobre cualquier cosa tengan mucho valor para muchos. Y es que la fama implica lo cuantitativo, la exposición de lo único a muchos, supone el espectáculo. Y nada más espectacular que el fútbol o la belleza. No es sorprendente que los mejores futbolistas se emparejen con misses y modelos (término que ya es definitorio de por sí).

También se da la posibilidad de alcanzar la fama por trabajos que no supongan lo espectacular. En ausencia de revelación biográfica alguna, un escritor puede ser famoso a través de su obra. Y lo que ocurre en el campo de la literatura, también se da, de otro modo, en la actividad artística y en la ciencia.

Una persona concreta puede hacerse célebre por su trabajo científico o artístico. Pero se da una gran diferencia entre esas dos actividades, sin las que nuestro mundo actual sería muy diferente. La relación obra - autor, tan clara en arte, lo es mucho menos en ciencia. Tal diferencia se da en dos órdenes, la fama real como reconocimiento y la fama pagada al autor o a otros que no tienen propiamente nada que ver con él.

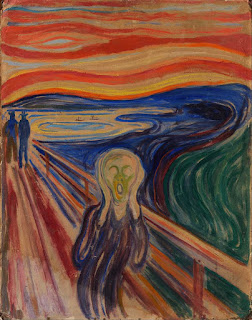

El caso de la pintura es sencillamente sintomático. “Les Femmes D’Alger” de Picasso alcanzó en una subasta los 179 millones de dólares. Bueno, es “un picasso” dirán algunos, como si Picasso estuviera aun en el cuadro. Quizá sea más llamativa la venta de una copia privada de “El grito” de Munch por casi 180 millones de dólares. Llamativa porque “el grito” parece reflejar la antítesis de lo que pueda ser su comprador. O quizá no; tal vez lo haya adquirido alguien que, además de rico, está angustiado ante la vida.

El caso de la pintura es sencillamente sintomático. “Les Femmes D’Alger” de Picasso alcanzó en una subasta los 179 millones de dólares. Bueno, es “un picasso” dirán algunos, como si Picasso estuviera aun en el cuadro. Quizá sea más llamativa la venta de una copia privada de “El grito” de Munch por casi 180 millones de dólares. Llamativa porque “el grito” parece reflejar la antítesis de lo que pueda ser su comprador. O quizá no; tal vez lo haya adquirido alguien que, además de rico, está angustiado ante la vida.

Picassos, Modoglianis, Rembrandts… ya son en plural, porque no se trata de cuadros de artista sino del artista mismo pluralizado en sus obras.

Quien tiene dinero y pretende a su vez la fama a través de él, no quiere hacerse con meras copias fotográficas o pictóricas de un original. Quiere el original mismo, lo que una vez se pintó como acto creativo y en lo que se pretende que ha quedado congelada la creación misma. Hemos llegado a una situación paradójica en la que la pintura se desvaloriza por el acto de comprarla. Aquí sí puede decirse con propiedad que sólo el necio confunde valor y precio, una confusión que, en general, no le fue permitida al pintor, singular, único, que creó “pintores” en forma de cuadros por poner su firma en ellos y que pudo haber muerto en la indigencia.

Eso no ocurre en el caso de los científicos. Los hay que alcanzan su celebridad por algún descubrimiento y eso suele reconocerse dándole su nombre a una ecuación, ley física o teoría. No hay un “darwin”, sino la Teoría de la Evolución de Darwin. Tampoco hay un “maxwell” sino sus ecuaciones obre el electromagnetismo. Es cierto que, a veces puede hablarse de un voltio o de un amperio, pero no es algo que se venda. Ni siquiera los vatios o kilovatios se venden; sólo cuando se multiplican por horas, lo que desvirtúa el valor de la persona que se llamó Watt.

Hay algo que puede explicar una diferencia tan palpable entre dos mundos que son, aunque distintos, creativos. Quizá la mejor explicación resida en que la ciencia es tarea de muchos y, en cierto modo (sólo en cierto modo, no como se desea desde utopías cuasi-religiosas), progresiva y acumulativa. Aunque no hubieran nacido Planck o Einstein, es probable que ahora o más tarde tuviéramos una mecánica cuántica y otra relativista.

Sólo algunos casos son especiales por su “modo” de hacer ciencia, pero son más bien personalidades históricas algo lejanas, como Newton, de quien se dijo que se reconocía al león por sus garras cuando, de modo anónimo, resolvió el problema de la braquistócrona, abriendo el paso al cálculo variacional.

Es cierto que hay científicos cuya celebridad se reconoce. El caso más claro se produce en la ceremonia anual de los premios Nobel. Pero … ¿quién recuerda a los premios Nobel de hace dos o tres años? Y ¿quién sabe realmente por qué se dan los del año en curso?

Los científicos actuales reconocidos no lo son tanto por su trabajo cuanto por su biografía. Tal vez el caso más conocido sea el de Hawking. Sus contribuciones han sido muy importantes, pero quizá menos que las de Edward Witten a quien sólo conocen en su casa (en su casa de físicos, se entiende). Richard Dawkins se ha hecho más famoso por su proselitismo ateo cientificista que por sus contribuciones reales a la Biología.

Un científico se hace célebre por la adversidad que rodea su trabajo, como Hawking, por la genialidad incuestionable, como Einstein, o, como suele ocurrir últimamente, por su paso a la divulgación científica y a la inmersión sacerdotal en la cosmovisión cientificista, como ocurre con Dawkins.

Claro que también los científicos han despertado de su ingenuidad, viendo que sus descubrimientos pueden patentarse. Desde esa perspectiva, ya no tienen que esperar a que sus obras, descubrimientos en este caso, sean vendidas post-mortem; pueden enriquecerse ya. Podríamos decir que, también en ese sentido pragmático, la ciencia ya no es lo que era.

En todos los ejemplos anteriores, la fama es algo que sucede como efecto colateral. Einstein no investigó en Física para hacerse famoso. Menos aún el aparentemente gris Planck. Tampoco parece que Modigliani pensara en el precio que adquirirían su obras una vez que él hubiera muerto.

Pero hay quien hace de la fama objetivo. En una ya vieja serie televisiva (“Fama”), la maestra de danza les decía a sus alumnos “Buscáis la fama, pero la fama cuesta y aquí es donde vais a empezar a pagar”. En ese caso, la fama ya era objetivo prioritario, pero a alcanzar mediante un saber artístico que implicaba esfuerzo.

Actualmente proliferan quienes buscan la fama por la fama, ofreciendo sólo lo que tienen, un cuerpo y su vagancia en los tristemente célebres “realities”. Y la logran, aunque sea efímera y vaya ligada al grado de estupidez propio y de quienes siguen sus tristes peripecias. Y es que, si uno hace de sus carencias espectáculo, tendrá muchos espectadores también carenciales que lo verán ejemplar o, al menos, un paliativo de sus propias miserias.